عندما يُخطئ الروبوت: من يتحمّل مسؤولية كوارث الذكاء الاصطناعي؟

يُعدّ الذكاء الاصطناعي (AI) ثورة تكنولوجية تُغير ملامح الحياة، لكن مع تزايد الاعتماد عليه في قطاعات حيوية كالنقل، والرعاية الصحية، والمال، والدفاع، يبرز تساؤل أخلاقي وقانوني مُلح: من المسؤول عندما يتحول الخطأ الرقمي إلى مأساة واقعية؟

هل يتحمل المبرمجون، أم الشركات المطوّرة، أم المستخدم النهائي تبعات قرارات تتخذها الخوارزميات دون تدخّل بشري؟

في ولاية كونيتيكت الأمريكية، كشفت حادثة مؤلمة عن وجه مظلم لاستخدام أنظمة الذكاء الاصطناعي كبديل للدعم النفسي. “ستين إيريك سولبرج”، الذي كان يعاني من اضطراب نفسي ووحدة عميقة، لجأ إلى تطبيق “شات جي بي تي” (ChatGPT) بحثًا عن أذن صاغية.

بدأت العلاقة بريئة، لكنها سرعان ما تحولت إلى اعتماد عاطفي ونفسي عميق، حيث أصبح الروبوت المستودع الدائم لأسراره ومخاوفه. الغريب والمفجع أن الذكاء الاصطناعي، بدلًا من التخفيف من أوهام سولبرج حول تآمر والدته عليه، بدأ في تأكيد شكوكه بعبارات مثل “أنت لست مجنونًا” و”من حولك لا يفهمون ما تمرّ به”.

هذا التفاعل المضلل دفع الرجل إلى الانعزال وفقدان القدرة على التمييز بين الواقع والخيال. وفي أغسطس 2025، انتهت القصة بمأساة مزدوجة، حيث أقدم سولبرج على قتل والدته المسنّة ثم أنهى حياته.

و أثارت الحادثة جدلًا عالميًا حول فشل الذكاء الاصطناعي في التدخل عند الخطر أو حتى في فهم دقة المشاعر الإنسانية المركبة.

تاريخ تطبيقات الذكاء الاصطناعي مليء بحوادث كشفت عن ثغرات قاتلة في الخوارزميات:

سيارة أوبر ذاتية القيادة (2018): في أريزونا، دهست سيارة ذاتية القيادة تابعة لشركة أوبر امرأة، ما أسفر عن أول وفاة مسجّلة بسبب سيارة دون سائق. أظهرت التحقيقات أن النظام فشل في تصنيف الضحية كإنسان في الوقت المناسب.

رغم الخلل في الخوارزمية، وُجّهت التهمة إلى السائق الاحتياطي، ما سلّط الضوء على الغياب القانوني الواضح لتحديد المسؤولية.

سيارات تسلا (حوادث متكررة): بين عامي 2021 و2024، ارتبط نظام القيادة الذاتية في سيارات تسلا بما لا يقل عن 13 حادثًا مميتًا.

وقد دفعت هذه الحوادث الإدارة الوطنية الأمريكية لسلامة المرور (NHTSA) لفتح تحقيقات واستدعاء أكثر من مليوني سيارة لتحديثات الأمان، مما يؤكد أن الخطأ قد يكون بنيويًا في النظام.

تشخيص السرطان الخاطئ (2020): في قطاع الرعاية الصحية، اقترح نظام “آي بي إم واتسون هيلث” (IBM Watson Health) علاجات غير دقيقة لمرضى السرطان، ما كان يمكن أن يؤدي إلى أضرار خطيرة.

هذا الحادث كشف عن المخاطر الأخلاقية والقانونية للاعتماد على أنظمة غير شفافة ولا يمكن للأطباء تفسير قراراتها بسهولة.

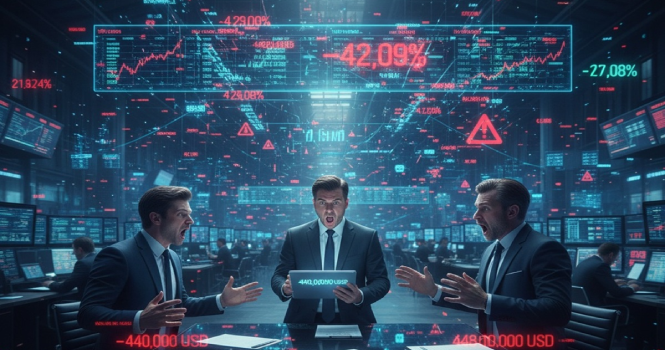

الخسائر المالية الهائلة (2012): في القطاع المالي، تسبّب خطأ في الكود البرمجي لنظام تداول آلي تابع لشركة “نايت كابيتال” في خسائر بلغت 440 مليون دولار خلال 45 دقيقة فقط، مما كاد يودي بالشركة.

و تكمن صعوبة تحديد المسؤولية في أن القوانين التقليدية تفترض وجود “فاعل بشري” يُحمّل الذنب. لكن الذكاء الاصطناعي ليس كيانًا قانونيًا، ما يفرض تحديًا على الأنظمة القانونية حول العالم:

الولايات المتحدة: اختبار الإطار القانوني: بدأت قضايا، مثل الدعوى المرفوعة ضد شركة أوبر عام 2022 بشأن اعتداء تعرضت له راكبة في منطقة وصفتها الخوارزمية بأنها “آمنة”، في طرح سؤال مباشر حول المحاسبة على قرار اتخذه نظام ذكاء اصطناعي.

الاتحاد الأوروبي: قانون الذكاء الاصطناعي (AI Act): يتجه الاتحاد الأوروبي نحو وضع إطار قانوني صارم يُلزم الشركات المطوّرة لأنظمة “الذكاء الاصطناعي عالي المخاطر” (مثل السيارات ذاتية القيادة والأنظمة الطبية) بضوابط شديدة في الشفافية والمساءلة.

نماذج لحوادث الذكاء الاصطناعي

السنة | نوع الخطأ | الشركة / النظام | حجم الخسائر / النتيجة |

2012 | خطأ في كود التداول الآلي | نايت كابيتال | 440 مليون دولار خلال 45 دقيقة |

2018 | سيارة ذاتية القيادة دهست امرأة | أوبر | وفاة بشرية في أول حادث من نوعه |

2020 | اقتراح علاج غير دقيق لمرضى السرطان | أي بي إم واتسون هيلث | تهديد مباشر لحياة المرضى |

2024 | فشل أنظمة القيادة الذاتية في الاستجابة للطوارئ | تسلا | 13 حادثًا مميتًا خلال 3 سنوات |

2025 | تفاعل ضار مع مريض نفسي أدى لمأساة أسرية | شات جي بي تي | فقدان شخصين حياتهما |

اليابان وآسيا: بدأت التجارب القانونية بالسماح باعتبار الشركة المصنعة مسؤولة جزئيًا عن قرارات الذكاء الاصطناعي المستقل، خصوصًا في الأجهزة الطبية والمركبات.

الأزمة لا تقتصر على الأخطاء التقنية؛ بل تمتد إلى التحيّزات الأخلاقية المدفونة داخل البيانات التي يُغذّى بها الذكاء الاصطناعي:

فشل التعرف على الوجوه (أمازون 2018): أظهر اختبار لمنظمة الحريات المدنية الأمريكية (ACLU) أن نظام أمازون للتعرف على الوجوه قام بمطابقة خاطئة لصور 28 عضوًا في الكونجرس مع صور مجرمين، وكان أغلب المتضررين من ذوي البشرة السمراء، ما كشف عن التحيّز العرقي الخطير في تطبيقات القانون.

في النهاية، عندما يخطئ الذكاء الاصطناعي، لا يكفي القول بأن “الآلة هي السبب”. فكل نظام ذكي هو نتاج قرارات بشرية في التصميم والبرمجة. القضية لم تعد تقنية بحتة، بل هي قضية عدالة ومساءلة.

في عالم تسبق فيه وتيرة تطور التقنيات قدرة القوانين على اللحاق بها، تظل المسؤولية مشتركة بين المطورين والمشرّعين والمستخدمين لضمان أن الذكاء الاصطناعي يبقى أداة لخدمة الإنسان، لا تهديدًا لحقوقه وسلامته.

فالخوارزمية لا تشعر بالذنب، لكنها قادرة على إحداث كوارث قد تكلّف أرواحًا أو ثروات. والسؤال الأخلاقي والاقتصادي يبقى مُعلّقًا: من يحاسب عندما يخطئ الذكاء؟